WordPressプラグインKB Robots.txtは、

検索エンジン用のrobots.txtを作成してくれるプラグインです。

robots.txtとは、

検索エンジンロボット(Googlebotなど)に、

検索エンジン上インデックスさせたくないURLなどがある場合に

クロールする対象を指定するために記述するものです。

このrobots.txtに記述しておくことで指定のURLをnoindexに指定することができ、

SEO上不利な重複コンテンツの解消をすることができます。

プラグインを使わずに手動でrobots.txtを作成しサーバーにアップロードしてもよいのですが、

プラグインKB Robots.txtを使用して有効化すれば

WordPressの管理画面からの記述が可能になりアップロードの手間が省けて便利です。

参照:重複メタデータとタイトルタグの解消方法 robots.txtの使い方解説

KB Robots.txtのインストールと有効化

プラグインKB Robots.txtを導入設定する方法を解説します。

- プラグインKB Robots.txtをインストールして有効化する

- プラグインKB Robots.txtの設定部分からクロール対象を設定する

上記の手順となります。

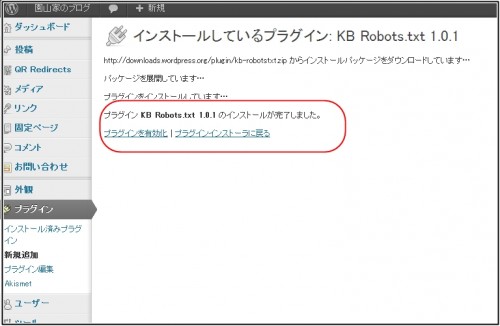

プラグインKB Robots.txtをインストールして有効化する

以下のどちらかの方法でプラブインをインストールします。

- プラグインKB Robots.txtをオフィシャルサイトからダウンロードし、アップロードする。

- 「Wordpressダッシュボード」→「プラグイン」→「新規プラグイン検索」でインストールする。

プラグインKB Robots.txtをインストールしたら、有効化します。

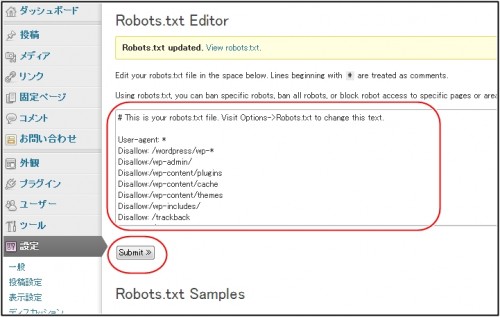

WordPressダッシュボードの「設定」部分に、「KB Robots.txt」の欄ができています。

こちらでrobots.txtの記述を設定していきます。

上記赤枠部分の「KB Robots.txt」の欄から設定します。

「KB Robots.txt」設定、上記の赤枠部分に条件をします。

記述の方法は、下記の記事を参照して下さい。

参照:重複メタデータとタイトルタグの解消方法 robots.txtの使い方解説

設定できましたら、赤枠の「Submit」をクリックしてセーブします。

設定が正しく完了していくと、グーグルボットがWEBサイトをクロール後に反映されていくと思います。

以上でKB Robots.txtの設定方法となります。

WEBサイトの最適化は随時構築していく

ウエブマスターツールに報告されるHTMLの改善はそこまで神経質になる必要はないですが、

サイトの最適化を随時行っていくことは重要な施策となります。

サイト構造によっては不必要な重複ページができてしまう場合も多々有ります。

ワードプレスでもカテゴリーページ以外にもタグページなど複数の重複metaができます。

このような部分を検索エンジンに対してどう伝えていくかによって

サイト評価に影響がある可能性もあるので随時最適化していきましょう。

コメント